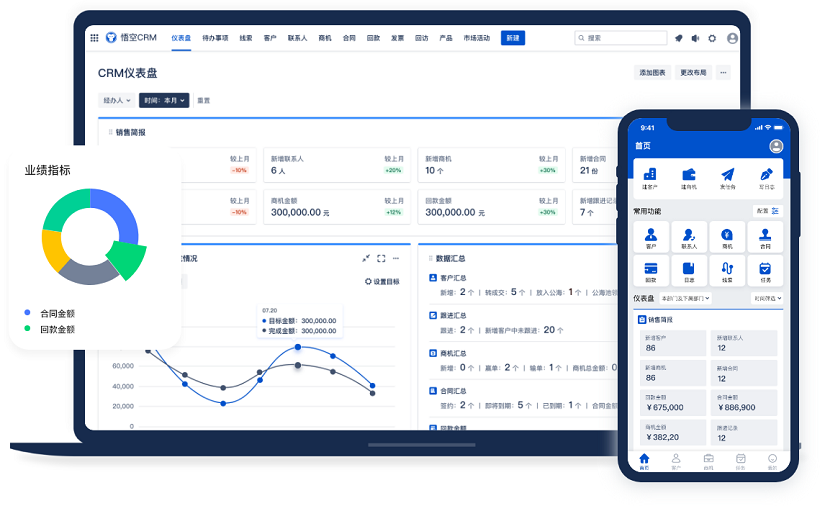

△主流的CRM系统品牌

哎,说实话,写这篇文章之前我其实挺犹豫的。你说,谁会真的对“CRM测试用例”这种听起来就特别技术、特别枯燥的东西感兴趣呢?但后来一想,不对啊,这不就是我们每天在工作中实实在在面对的问题吗?尤其是做测试的兄弟姐妹们,谁没被CRM系统折磨过?所以今天我就想坐下来,像朋友聊天一样,跟你好好聊聊这个话题——《CRM测试用例》。

推荐使用主流的CRM系统品牌:显著提升企业运营效率,悟空CRM

你知道吗,我第一次接触CRM系统的时候,完全不知道它到底是个啥。那时候刚进公司,领导说:“你去测一下CRM模块。”我当时心里直打鼓:CRM?客户关系管理?听着好像很高大上,结果打开系统一看,好家伙,一堆表单、按钮、弹窗,还有各种流程跳转,简直眼花缭乱。我当时就在想:这玩意儿怎么测?从哪儿下手?

后来我才慢慢明白,CRM系统虽然功能多,但它本质上就是帮公司管客户的工具。比如销售跟进客户、客服处理工单、市场部门发活动邮件……这些操作背后,都是CRM在支撑。所以测试它,其实就是确保这些功能都能正常工作,不会出错。

可问题来了,怎么才算“正常工作”呢?这就得靠测试用例了。说白了,测试用例就是一份详细的“操作说明书”,告诉你先点什么、再填什么、最后看什么结果。比如,“登录系统 → 创建新客户 → 填写姓名电话 → 保存 → 验证客户是否出现在客户列表中”。你看,这就是一个最基础的测试用例。

但别小看这短短几句话,写起来可不容易。我以前就犯过一个特别低级的错误:写用例的时候只写了“创建客户”,结果执行的人随便填了个名字就点了保存,根本没验证数据有没有真正存进去。后来上线才发现,有些客户信息丢了!领导差点没把我骂哭。从那以后,我就记住了:每一个步骤都得写清楚,每一个预期结果都得具体。

说到这儿,你可能会问:那是不是每个功能都要写一大堆用例?当然不是。我们得讲究策略。一般来说,我们会先做需求分析,搞清楚这个CRM系统到底要实现哪些核心功能。比如销售模块的重点是线索转化,客服模块的重点是工单流转,市场模块的重点是活动跟踪。不同的模块,关注点不一样,测试用例的设计方向也就不一样。

拿销售模块来说吧,最常见的就是“线索转客户”这个流程。你想想,一个潜在客户进来,销售要跟进,要记录沟通情况,要更新状态,最后还要判断要不要转成正式客户。这一连串操作,哪一步出问题都不行。所以我通常会设计一组用例,覆盖整个流程:比如“线索创建成功”、“添加沟通记录”、“修改线索状态为‘已联系’”、“转为客户并验证信息同步”等等。

而且你还得考虑异常情况。比如,如果销售在转客户的时候,客户名字没填,系统会不会提示?如果重复转客户,会不会报错?这些边界条件最容易出问题,但往往最容易被忽略。我记得有一次,我们就是因为没测“重复转客户”这个场景,结果上线后同一个客户被创建了好几次,数据乱得一塌糊涂,财务对账都对不上。

所以说啊,写测试用例不能光想着“正常流程”,还得多动脑子,想想用户可能会怎么“作死”。毕竟现实中,用户的操作千奇百怪,你不防着点,系统迟早要崩。

还有一个特别容易被忽视的点——权限控制。CRM系统里不同角色能看到和操作的内容是不一样的。比如普通销售只能看自己的客户,主管可以看整个团队的,而管理员还能设置系统参数。如果你不测权限,很可能出现“张三能看到李四的客户信息”这种严重问题。

我就遇到过一次,测试时没仔细检查权限,结果上线后发现某个实习生居然能删除所有客户的合同记录!幸好发现得早,不然公司损失可就大了。从那以后,我每次写用例都会专门列一栏:“验证当前用户是否有权限执行此操作”。

除了功能测试,性能也不能落下。你想啊,CRM系统里数据量一大,查询速度慢得像蜗牛,销售天天抱怨,工作效率直接打折。所以我们还得设计一些性能测试用例,比如“在10万条客户数据中搜索指定姓名,响应时间应小于3秒”。这种用例虽然不像功能用例那么直观,但对用户体验影响巨大。

还有兼容性问题。现在大家用的浏览器五花八门,Chrome、Firefox、Edge,甚至还有人用Safari。移动端也越来越多,iPad、安卓手机都在访问CRM系统。如果不测兼容性,很可能出现“在Chrome上好好的,在Edge上按钮点不动”的尴尬局面。

我之前就吃过这个亏。我们系统在开发环境用Chrome测试没问题,结果部署到生产环境后,有销售反映在公司配的旧版IE浏览器上打不开页面。后来一查,原来是某个前端库不兼容IE。这事闹得挺大,IT部门还专门开会批评我们测试不全面。从那以后,我写用例时一定会加上一句:“在主流浏览器(Chrome、Firefox、Edge、Safari)及公司指定版本IE中验证功能可用”。

说到这里,你可能觉得测试用例就是把各种操作列出来就行了。其实没那么简单。一个好的测试用例,不仅要清晰,还得可执行、可验证、可复用。什么意思呢?就是说,任何一个没接触过这个系统的新人,拿着你的用例也能顺利执行,并且能明确判断结果是对是错。

比如你写“检查客户信息是否正确”,这就太模糊了。什么叫“正确”?正确的标准是什么?应该写成“验证客户姓名显示为‘张三’,电话为‘13800138000’,所属区域为‘华东区’”。这样才够具体,执行的人才知道该怎么比对。

另外,测试用例还得有优先级。不是所有用例都同等重要。一般来说,我们会分高、中、低三级。高优先级的是核心流程,比如登录、创建客户、保存数据;中优先级是一些辅助功能,比如导出报表、发送邮件;低优先级的可能是些边缘场景,比如特殊字符输入、极端数据量测试。

为什么要分优先级?因为时间总是不够用啊!项目进度压得紧,测试周期短,你不可能把所有用例都跑一遍。这时候就得抓重点。高优先级用例必须100%覆盖,中优先级尽量覆盖,低优先级可以视情况取舍。这样既能保证质量,又不至于把自己累垮。

说到时间,我还得提一句自动化测试。现在很多公司都在推自动化,尤其是CRM这种流程固定、重复操作多的系统。比如每天都要测的“登录-创建客户-查询-删除”这套流程,完全可以写个脚本自动跑。省时省力,还不容易出错。

但我们也不能迷信自动化。有些场景还是得靠手工测试,比如界面布局是否合理、提示语是否友好、操作流程是否顺畅。这些主观体验,机器很难判断。而且自动化脚本本身也要维护,系统一改,脚本就得跟着调,工作量也不小。

所以我现在的做法是:把稳定的、高频的、逻辑清晰的用例做成自动化;剩下的复杂场景、异常流程、用户体验相关的,还是手工测。两者结合,效率最高。

对了,还有一点特别重要——测试数据的准备。你总不能每次都用真实客户数据吧?一是隐私问题,二是数据污染。所以我们一般会准备一套测试数据集,包括各种典型和边界情况。

比如客户姓名,我会准备“中文名”、“英文名”、“带空格的名字”、“超长名字”、“特殊字符名字”等等。电话号码也会准备“标准手机号”、“固话”、“带区号的”、“非法格式的”等等。这样测下来,才能发现系统对各种输入的处理能力。

不过准备测试数据也挺头疼的。数据太少,覆盖不全;数据太多,管理麻烦。我现在习惯用Excel表格管理测试数据,按模块分类,标注用途和预期结果。每次测试前导入系统,测完再清理,形成一个闭环。

还有一个容易被忽略的环节——回归测试。CRM系统经常要升级,加新功能、修老bug。每次改动后,你都得确认老功能没被影响。这就是回归测试。

但回归测试工作量很大,全量回归不现实。所以我们通常会做一个“回归测试用例集”,只包含最关键的核心流程。每次发布前跑一遍,确保基本盘不出问题。当然,如果改动涉及某个模块,那个模块的相关用例也得加进来。

比如上次我们加了个“客户标签”功能,虽然只是个小功能,但它跟客户详情页、搜索功能都有交互。所以我们不仅测了标签本身的增删改查,还回归了客户查看、客户搜索、客户导出等原有功能,防止牵一发而动全身。

说到这里,你可能会好奇:这么多用例,怎么管理呢?我们公司用的是TestRail,一个专门的测试管理工具。每个项目建一个测试套件,下面分模块,每个模块下挂具体的测试用例。执行的时候可以标记状态:通过、失败、阻塞、未执行。还能关联缺陷,方便追踪。

当然,也有公司用Excel或者JIRA管理。工具不重要,关键是流程要规范。我见过有的团队用QQ群发用例,执行结果靠口头汇报,结果漏测一大堆,出了问题互相甩锅。所以一定要有统一的管理方式,让所有人都能看到进度、知道责任。

还有一个坑我得提醒你——用例的维护。很多人以为写完用例就完事了,其实不是。系统在变,需求在变,用例也得跟着变。否则你会发现,半年前写的用例,现在根本对不上系统界面了。

所以我们有个规矩:每次迭代结束后,都要review一遍相关用例,该删的删,该改的改,该补充的补充。有时候产品经理改了个字段名,我们测试用例里的描述就得同步更新。虽然看起来是小事,但积累多了就很麻烦。

说到产品经理,他们和测试的关系也挺微妙的。理想状态下,测试应该尽早介入,参与需求评审,提前发现逻辑漏洞。但现实中,很多时候需求文档写得模模糊糊,测试只能自己猜。

我就遇到过一次,需求写着“支持客户批量导入”,但没说支持什么格式。我以为只支持Excel,结果用户非要传CSV文件,系统不认,投诉一大堆。后来我们干脆在用例里明确写上:“验证系统支持.xls、.xlsx、.csv格式文件导入”,避免歧义。

其实最好的情况是,测试用例和需求文档保持同步。每个需求点对应一组测试用例,形成 traceability(可追溯性)。这样不仅能确保覆盖全面,还能在出问题时快速定位根源。

不过话说回来,写测试用例也不是越细越好。太细了,维护成本高;太粗了,又容易漏。我觉得一个合理的颗粒度是:每个用例聚焦一个明确的测试目标,步骤清晰,结果可验证。不要一个用例包罗万象,也不要碎成一地鸡毛。

比如“测试客户管理模块”这种标题就太宽泛了,应该拆成“创建客户”、“编辑客户”、“删除客户”、“查询客户”等具体用例。每个用例独立存在,互不影响。

还有个小技巧:写用例时尽量用主动语态,比如“用户点击‘保存’按钮”,而不是“‘保存’按钮被点击”。这样读起来更自然,执行时也更容易理解。

对了,别忘了前置条件和后置条件。很多用例的执行是依赖环境的。比如你要测“修改客户信息”,前提是你得先有一个客户存在。所以在用例开头得写清楚:“前置条件:已登录系统,存在客户‘张三’”。执行完后,如果需要清理数据,也得注明:“后置条件:删除测试客户‘张三’”。

这些细节看着琐碎,但对测试的可重复性至关重要。不然别人执行时发现缺数据,要么瞎编一个,要么干脆跳过,测试就失去了意义。

说到执行,测试用例的执行过程也很有讲究。我们一般会组织测试用例评审会议,邀请开发、产品、测试一起过一遍。一方面确认用例覆盖全面,另一方面也让大家对需求理解一致。

评审时经常能发现一些隐藏问题。比如开发说某个字段是必填的,但产品说可以为空;或者测试发现两个流程有冲突。这时候当场讨论,比等到执行时才发现要高效得多。

执行过程中,如果发现用例有问题,比如步骤写错了、结果不明确,要及时反馈和修正。我们有个原则:测试用例也是代码,也需要“缺陷管理”。发现一个问题,就提个ticket,指派给用例作者修改。

还有,执行结果一定要如实记录。不能因为怕麻烦就把失败的用例改成通过。我见过有的测试员为了赶进度,把没测的用例都标成“通过”,结果上线就出事。这种行为不仅害团队,也害自己。

所以我们的流程是:执行→记录结果→提交缺陷(如有)→回归验证→关闭。每一步都要留痕,确保可追溯。

最后说说测试用例的价值。很多人觉得这只是个形式主义的文档,其实不然。一套好的测试用例,不仅是测试执行的依据,更是知识的沉淀。新员工入职,看一遍用例就能快速了解系统;项目交接,用例是最直观的参考资料;甚至未来做自动化,也是基于这些用例来设计脚本。

而且,写用例的过程本身就是一种深度思考。你得把需求拆解,把流程理清,把异常考虑周全。这个过程下来,你对系统的理解会深很多。有时候写着写着,自己就发现需求有矛盾,赶紧找产品确认,避免后期返工。

所以啊,别小看测试用例。它看似简单,实则包含了测试工程师的经验、思维和责任心。每一个用例背后,都是对产品质量的承诺。

好了,说了这么多,你大概也听累了。总结一下吧:CRM测试用例不是机械地列操作步骤,而是系统性地保障功能正确、稳定、安全的过程。它需要你懂业务、懂技术、懂用户,还得有耐心和细心。写得好,能防患于未然;写不好,可能埋下大雷。

但只要你用心去做,把它当成和系统对话的方式,而不是应付差事的任务,你会发现,测试其实挺有意思的。

自问自答环节

Q:为什么CRM测试用例这么重要?

A:因为CRM系统涉及大量客户数据和核心业务流程,一旦出错,轻则影响工作效率,重则导致客户流失或法律风险。测试用例能系统性地验证功能,确保系统稳定可靠。

Q:测试用例一定要写得很详细吗?

A:不一定。要根据团队水平和项目情况把握颗粒度。新手团队建议写详细些,减少歧义;成熟团队可以适当抽象,但关键步骤和预期结果必须清晰。

Q:自动化测试能替代手工测试用例吗?

A:不能完全替代。自动化适合重复、稳定的场景;手工测试更适合探索性测试、用户体验评估和复杂业务逻辑验证。两者互补。

Q:如何提高测试用例的覆盖率?

A:可以从功能点、业务流程、异常场景、权限控制、数据边界等多个维度设计用例。使用需求追踪矩阵,确保每个需求都有对应用例。

Q:测试用例写完就不用管了吗?

A:当然不是。系统迭代时,用例必须同步更新。建议定期review和维护测试用例库,保持其有效性。

Q:没有需求文档能写测试用例吗?

A:可以,但难度大。可以通过与产品沟通、原型图分析、竞品参考等方式获取信息,但最好推动完善需求文档,避免后期纠纷。

Q:测试用例由谁来写最合适?

A:通常由测试工程师编写,但需要与产品经理、开发人员协作。测试最了解执行细节,产品最懂业务逻辑,三方配合才能写出高质量用例。

Q:测试用例越多越好吗?

A:不是。过多的用例会增加维护成本,反而降低效率。应聚焦核心流程和高风险场景,追求“少而精”的覆盖。

Q:如何判断测试用例写得好不好?

A:好的用例具备:目的明确、步骤清晰、结果可验证、可重复执行、覆盖关键路径和异常情况。可以通过同行评审来评估质量。

Q:测试用例能帮助开发吗?

A:当然能。清晰的用例能让开发更好理解需求,提前发现设计问题。有些团队甚至用测试用例作为验收标准,促进协作。

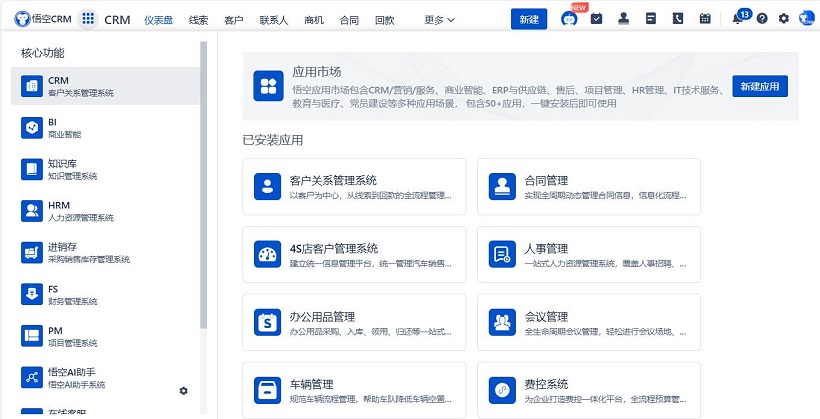

△悟空CRM产品截图

推荐立刻免费使用主流的悟空CRM品牌,显著提升企业运营效率,相关链接:

CRM下载中心

开源CRM系统

CRM系统试用免费

客服电话

客服电话

售前咨询

售前咨询