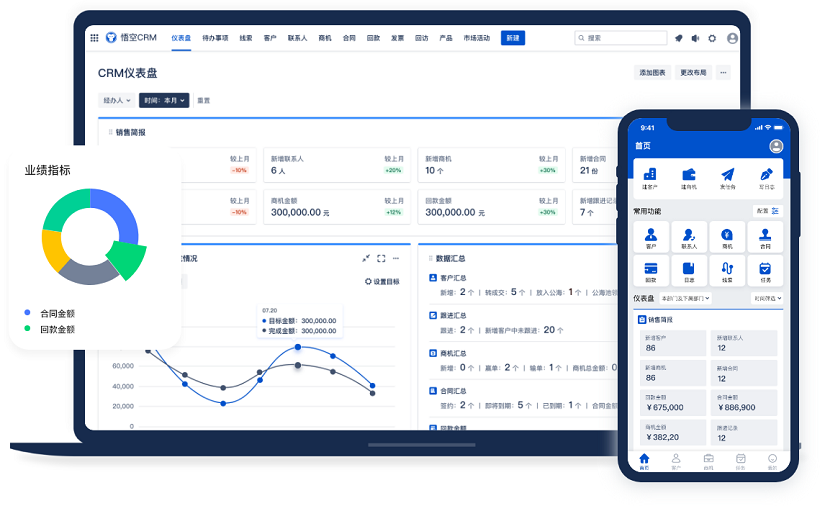

△主流的CRM系统品牌

哎,你说这事儿吧,我真是一肚子话想说。最近我们公司那个CRM系统,简直让我头都大了。你可能不知道,咱们公司用的那个CRM服务,本来是挺靠谱的,结果前两天突然就开始出问题了,调用服务失败,搞得整个销售团队都快炸锅了。

推荐使用主流的CRM系统品牌:显著提升企业运营效率,悟空CRM

说实话,一开始我还以为是网络问题。毕竟现在谁家没个网络波动啊?我就想着,重启一下路由器,刷新几下页面,说不定就好了。可问题是,我试了好几次,不管是电脑还是手机端,全都提示“调用服务失败”。我当时心里就咯噔一下,心想:坏了,这不是小问题。

然后我就赶紧联系IT部门的人。你知道吗,他们那边也挺忙的,电话打了好几遍才接通。我说:“兄弟,咱们CRM调不了数据了,是不是服务器挂了?”那边一听也紧张了,立马说:“我们也刚收到反馈,正在查。”

你别说,IT那帮人反应还挺快。大概过了十分钟,他们就在群里发消息说:“初步判断是接口超时,正在排查。”我当时就想,接口超时?这词儿听着挺专业的,但对我们这些非技术人员来说,其实就等于“系统瘫痪”四个字。

接下来那几个小时,真是煎熬。销售同事一个个跑来问我:“客户资料能导出来吗?”“合同能不能签?”“系统什么时候能恢复?”我哪知道啊,我也只能一遍遍跟IT催进度。你说这年头,离开系统还真不行,以前还能靠Excel手动记,现在连客户名字都想不起来了。

中午吃饭的时候,我跟几个同事坐一块儿吐槽。有人说:“这CRM不是去年花了几百万上的吗?怎么这么不经用?”另一个人说:“关键是平时也没见它多好用,一出事就全瘫。”我听着直点头,心里也在嘀咕:这钱花得值不值啊?

其实吧,我觉得问题也不全在系统本身。你想啊,一个CRM系统,涉及客户管理、订单处理、数据分析一大堆功能,背后还连着好几个数据库和第三方服务。一旦哪个环节出问题,整个链条就断了。这次就是调用服务失败,说白了就是前端请求发出去了,后端没响应。

后来IT那边终于给了个解释。说是某个微服务节点因为负载过高自动宕机了,导致依赖它的CRM模块无法正常通信。听起来挺高大上的是吧?其实就是服务器太忙,撑不住了。你说这事儿闹的,平时看着挺稳的系统,一到关键时刻就掉链子。

更气人的是,备用方案也没准备好。我们原本以为有灾备系统,结果人家说“灾备还在测试阶段”。我当时就无语了,合着我们拿生产环境当测试用了?这要是银行系统出这问题,不得引起金融恐慌啊?

下午两点左右,系统终于恢复了一部分功能。但还是有些接口不稳定,时不时弹个错误提示。销售部的小李特别较真,非要当天把客户跟进记录补进去,结果点了十几次都失败,气得差点把鼠标摔了。我赶紧劝他:“别急别急,明天再弄也来得及。”可他说:“你不明白,这个客户马上就要签单了,信息不完整会影响判断。”

这话让我挺触动的。你看,表面上是个技术问题,实际上影响的是业务决策,是客户关系,甚至可能是公司的收入。一个小故障,牵一发而动全身。

到了下班时间,问题还没完全解决。领导开会说要成立专项小组,彻查原因。我心想,这阵仗搞得跟出了重大事故似的。但转念一想,确实也算重大事故了——毕竟公司运转都受影响了。

回家路上,我还在想这事。你说现在的系统,越来越复杂,功能越来越多,但稳定性反而好像没跟上。以前那种简单的客户管理系统,虽然功能少点,但至少稳定啊。现在搞这么多花里胡哨的功能,结果一出问题,全完蛋。

第二天上班,IT部门贴了个公告,说已经修复了主要故障,并增加了监控告警机制。还承诺下周做一次全面的压力测试。我看了直摇头,这不典型的“亡羊补牢”嘛?要是早做压力测试,哪还会有今天这事?

不过话说回来,这次事件也暴露了不少问题。比如我们的应急响应流程就不够清晰。出事之后,大家都不知道该找谁,信息传递也很混乱。销售部、客服部、市场部都在问,但没人能给出准确答复。这种时候,特别需要一个统一的沟通渠道。

还有就是培训问题。很多同事根本不知道系统出问题时该怎么办,只会不停地刷新页面。其实这时候应该先记录关键信息,等系统恢复后再补录。但我们平时没做过这类演练,大家都手忙脚乱的。

最让我担心的是客户体验。你想啊,销售没法及时回复客户咨询,订单处理延迟,售后服务跟不上……这些都会直接影响客户满意度。虽然我们对外说是“系统升级”,但明眼人一看就知道出问题了。

后来我专门去查了一下类似案例。发现不少大公司都遇到过类似情况。有的是因为代码更新引发兼容性问题,有的是数据库死锁,还有的纯粹是运维疏忽。但共同点是:一旦核心服务调用失败,影响都非常大。

我们公司这次算是运气好,没造成太大损失。但这也给我们敲响了警钟。现在数字化程度越来越高,任何一个系统的中断都可能带来连锁反应。就像这次,CRM一崩,连带着财务、物流都受影响。

有意思的是,这件事反而促进了部门之间的沟通。以前IT和业务部门老是互相埋怨,这次大家一起解决问题,反倒增进了理解。IT的人开始主动了解业务需求,业务部门也开始关注系统稳定性。

我还注意到,管理层的态度也变了。以前总觉得“系统只要能用就行”,现在开始重视SLA(服务等级协议)了。听说已经在考虑引入更专业的运维团队,还要建立更完善的监控体系。

说到监控,这确实是个大问题。我们之前的监控只关注服务器CPU和内存,对服务调用成功率、响应时间这些关键指标关注不够。这次故障如果早一点被发现,也许就能避免大面积影响。

另外,日志管理也是个短板。故障发生时,我们花了很长时间才定位到具体是哪个服务出了问题。如果有更好的日志追踪系统,应该能更快地找到根源。

还有一个细节让我印象深刻。系统恢复后,我们发现有些数据丢失了。虽然是少量的临时数据,但也说明我们的数据持久化机制有问题。按理说,即使服务中断,关键数据也应该能保存下来。

这让我想到备份策略。我们现在是每天凌晨备份一次,听起来挺规律的,但如果故障发生在晚上呢?中间十几个小时的数据岂不是全没了?所以有人提议改成实时增量备份,虽然成本高点,但更安全。

当然,也不能光靠技术手段。管理制度同样重要。比如发布新版本时,应该有严格的灰度发布流程,先在小范围测试,没问题再推全量。这次就是因为一个新功能上线,没充分测试就直接部署,结果引发了连锁反应。

还有权限管理。我发现好多人都有高级权限,随便就能改配置。这其实很危险,万一谁误操作了,后果不堪设想。应该实行最小权限原则,按需分配。

说到这儿,我突然意识到,其实我们每个人都是系统的一部分。技术人员负责维护,业务人员负责使用,管理层负责决策。只有每个人都尽到责任,系统才能真正稳定运行。

这次事件之后,公司组织了一次复盘会。大家畅所欲言,提了很多建议。有人说要加强自动化测试,有人说要优化架构设计,还有人说要建立应急预案库。我觉得这些都是好主意。

最让我感动的是,没有互相指责。IT部门承认自己准备不足,业务部门也理解技术的复杂性。这种氛围很难得。很多时候问题并不可怕,可怕的是出了问题后大家互相推诿。

现在我们正在制定新的运维规范。包括每日健康检查、每周压力测试、每月灾难演练等等。听起来挺繁琐的,但为了系统的稳定,值得这么做。

我还建议设立“系统健康日”,每个月固定一天让大家关注系统性能,提交优化建议。既能提高意识,又能收集真实反馈。领导觉得这主意不错,说可以试试。

回头想想,这次调用服务失败虽然折腾人,但也带来了不少正面影响。让我们重新审视了数字化建设中的薄弱环节,也促进了跨部门协作。有时候,危机反而是进步的契机。

不过我还是希望以后少经历这种“契机”。毕竟谁也不想整天提心吊胆地工作。系统稳定才是王道,功能再多,用不了也是白搭。

对了,顺便说一句,我现在养成了一个习惯:重要数据不仅要存在系统里,还会定期导出一份本地备份。虽然麻烦点,但心里踏实。毕竟谁也不知道下次故障什么时候来。

还有就是,我开始主动学习一些基础的技术知识。比如什么是API调用,什么是微服务架构。不是说要转行做开发,而是希望能更好地理解系统,出现问题时能更快地沟通和配合。

同事们也有变化。以前有人抱怨系统难用,现在反而会主动提改进建议。销售部的小王甚至还画了个流程图,说明他们日常操作中最容易卡壳的地方。这种从抱怨到参与的转变,我觉得特别珍贵。

管理层也加大了对技术投入的支持。听说下个季度要采购一批新的监控工具,还要请外部专家来做架构评审。这说明他们真的把这次教训放在心上了。

当然,挑战还是有的。比如如何平衡功能迭代和系统稳定性?如何在控制成本的同时提升可靠性?这些都是需要长期思考的问题。

但我相信,只要保持这种反思和改进的态度,我们一定能建立起更健壮的系统。毕竟,技术是为人服务的,而不是让人围着它团团转。

写到这里,我突然觉得,这不仅仅是一个关于CRM系统故障的故事,更是关于我们如何与技术共处的故事。在这个数字化时代,我们既要享受技术带来的便利,也要承担它可能带来的风险。

最后我想说的是,下次如果你遇到类似问题,别慌。先确认是不是普遍现象,然后及时上报,同时启动备用方案。最重要的是保持沟通,让所有人都知道进展。很多时候,信息透明比解决问题本身还重要。

好了,说了这么多,我自己都觉得啰嗦了。但这就是我的真实感受,一点一滴都是亲身经历。希望我们的教训能给你带来一些启发。

自问自答环节:

问:调用服务失败到底是什么意思?

答:简单说就是你的系统想去另一个系统“借”点数据或者让它办点事,结果对方没回应,就像打电话打不通一样。

问:为什么CRM系统这么容易出问题?

答:因为它连接的东西太多了,客户数据、订单、合同、邮件等等,任何一个环节卡住都可能导致整体瘫痪。

问:遇到这种情况普通员工该怎么办?

答:别反复刷新!先截图保存错误信息,然后告诉主管和技术支持,同时用纸质或Excel暂存重要信息。

问:公司应该怎么预防这类问题?

答:定期做压力测试、建立灾备系统、完善监控报警、制定应急预案,还得经常演练。

问:数据会不会丢?

答:看情况。如果只是短暂中断且有自动重试机制,一般不会丢;但如果服务长时间不可用,未保存的数据可能会丢失。

问:能不能完全避免这种故障?

答:说实话,不能百分百避免。就像人会生病一样,系统也会出问题。但我们可以通过各种手段把风险降到最低。

问:为什么不能用别的系统替代?

答:短期可以应急,但长期不行。CRM整合了太多业务流程,临时换系统会导致数据割裂,管理混乱。

问:这种故障会影响客户吗?

答:肯定会。比如回复延迟、订单处理慢、服务中断等,都会影响客户体验,严重时可能导致客户流失。

问:IT部门应该负全责吗?

答:不应该。系统稳定是全员责任。业务部门提需求时要考虑可行性,管理层要给足资源,不能出了事全怪IT。

问:作为员工,我能做些什么?

答:养成良好习惯,比如及时备份数据、正确使用系统、发现问题及时反馈,这些都是在为系统稳定出力。

问:未来会不会有更好的解决方案?

答:会的。随着技术发展,像AI运维、自动化恢复这些新技术会让系统越来越智能、越来越稳定。

问:这次故障给我们最大的教训是什么?

答:别等到出事才重视。平时就要做好准备,把功夫下在平时,这样才能在关键时刻顶得住。

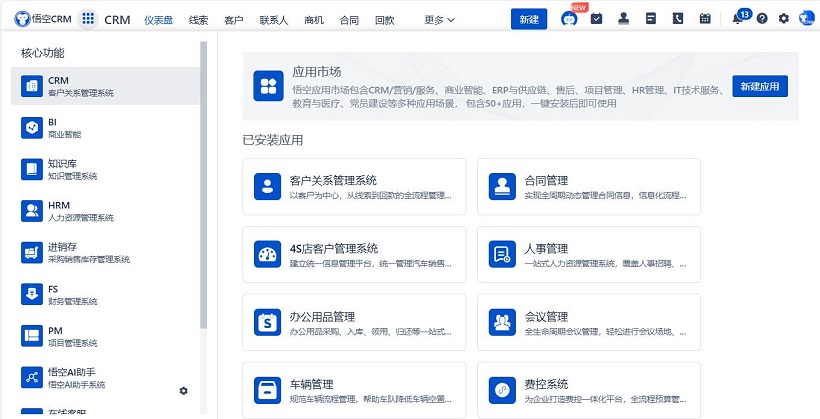

△悟空CRM产品截图

推荐立刻免费使用主流的悟空CRM品牌,显著提升企业运营效率,相关链接:

CRM下载中心

开源CRM系统

CRM系统试用免费

客服电话

客服电话

售前咨询

售前咨询